Nvidia A100 - az elsõ Ampere grafikus processzor

Bár sokan várták, a frissen bejelentett fejlesztés még nem a lakossági RTX modellekkel konkurál![]()

A járvány miatt elmaradt GTC konferencia, és a még márciusról is tovább csúsztatott online bemutató miatti hosszas várakozásnak vége, megtörtént az elsõ nagy bejelentés. Bár sokan reménykedtünk, hogy az otthoni felhasználókra is gondolnak majd, Jensen Huang vezérigazgató ezalkalommal csak az új Ampere technológia újdonságaival készült, melyeket az eddigi legméretesebb ipari GPU-szörnyeteggel együtt mutatott be.

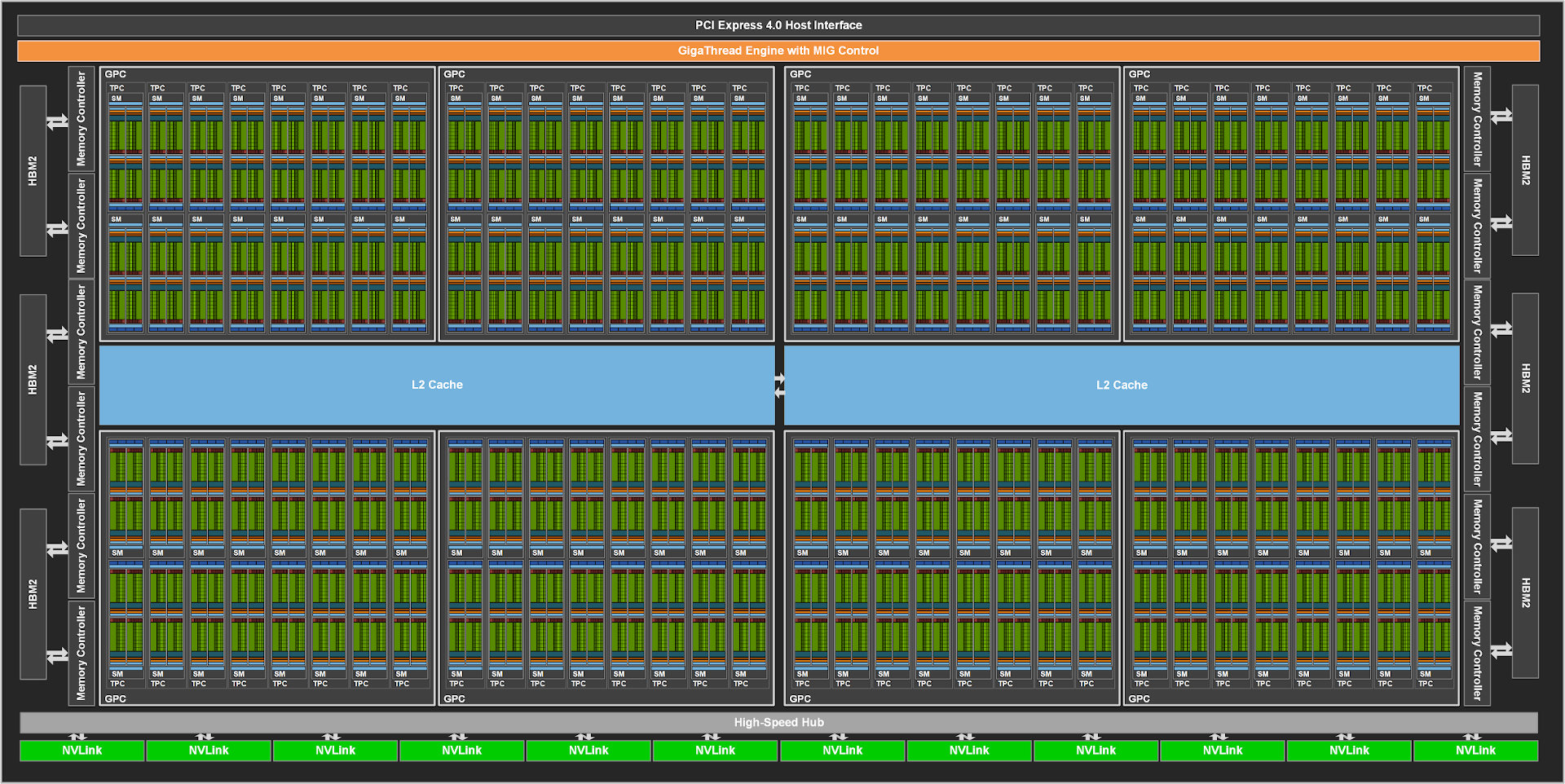

A bejelentés középpontjában természetesen az új Ampere mikroarchitektúra állt, mely elsõsorban a 2017 végén bevezetett Volta leváltására hivatott, és bár a Turing köré épülõ RTX sorozat helyét is az Ampere technológiával készült modellek váltják majd, az RTX 3000-rõl egyelõre nem esett szó. Az újdonság pedig nem más, mint a GA100 mely a valaha készült legtekintélyesebb GPU mind kapacitásban, mind fizikai kiterjedésében. Az adatközpontok új generációjának meghajtására készült lapka rálicitál az elõd GV100 képességeire, így természetesen a TSMC 12nm-es node-járól a 7nm-esre költözik át, sosem látott elõrelépést produkálva. Elõször is a tranzisztorok száma 21,1 milliárdról 54,2 milliárdra gyarapodott, ráadásul ezt látványos növekedést úgy éri el, hogy a 826 mm²-res lapka mindössze 16 mm²-rel nagyobb elõdjénél. Az összehasonlításhoz érdemes megnézni, hogy az elõzõ generáció csúcsát jelentõ RTX 2080 Ti kártya 754 mm²-res lapkája 18,6 milliárd tranzisztort tartalmaz.

A CUDA magok száma 5120-ról 6912-re nõtt, a lebegõpontos FP32 számítási teljesítmény pedig egy izmos 4.2 TERAFLOP pluszt könyvelhet el másodpercenként. A számítási kapacitás jelentõs növekedéséhez pedig 40GB méretû HBM2 fedélzeti memória is hozzájárul, méghozzá 2.43 Ghz-es órajellel, 1.555 TB/s sávszélességgel, a GPU-val történõ kommunikációt pedig az 5120 bites adatbusz segíti. Érdekesség, hogy elvileg a hat HBM2 lapkából egy inaktív, tehát nem kizárt, hogy egy még erõsebb változatban további 1024-bit járul hozzá az amúgy is komoly összképhez.

Ahogy arra számíthattunk, az elõadásban szép nagy szelet jutott a mesterséges intelligenciára épülõ fejlesztéseknek, és a gépi tanulásnak, melyben hatalmas elõrelépést értek el, és ahogy is hangsúlyozza, az jövõ már nem a szervereké, hanem az adatközpontoké, (avagy szuperszámítógépeké, ha úgy jobban tetszik). A Tesla V100 GPU sem volt gyenge ezen a téren, de az Ampere A100 nem véletlenül kapta a "Tensor Core GPU" fedõnevet. Bár megtévesztõ lehet, hogy a V100 összesen 640 Tensor magja helyett itt csak 432 szerepel, valójában továbbfejlesztett struktúrájú magokról van szó, melyekkel nagyjából 30%-kal nõtt az összteljesítmény, így láthatóan a teljes fókusz a gépi tanulásra irányul.

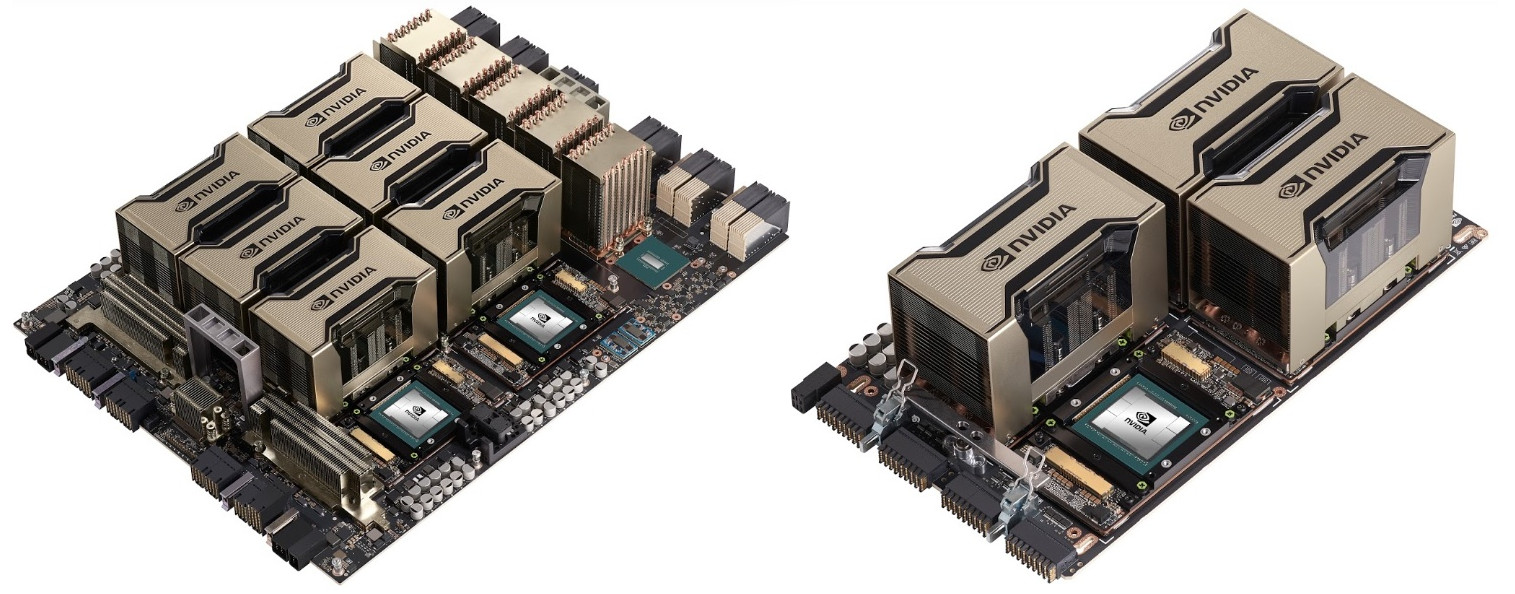

Fontos újítás a Pascal architektúrával együtt bevezetett NVLINK új változata is. Az NVLink 3-as verziója, 50 Gbps sávszélességével nagyjából duplázza az NVLink 2 adatátviteli képességét, ezzel nem csak a GPU és CPU közt zajló kommunikációt gyorsítja meg jelentõs mértékben, de a több GPU-s rendszerek számára is nagy löketet ad. Az A100 amúgy 12 darab NVLinket kapott, ez a 600 Gbps pedig szintén rádupláz a V100-ra. Ehhez mérten fogyasztás is érezhetõen nõtt, de 400 watt ebben a kategóriában nem számít extrémnek. A több GPU-s rendszerekben 8 GPU alatt az NVLink látja el az összeköttetést, afölött azonban már az NVSwitch elosztóra is szükség van.

Ez tehát még nem az átlagos halandóknak szánt termékvonal, hiszen az A100 pont a grafikai munkában és a játékban nem vethetõ be. Természetesen ez nem azt jelenti, hogy az Nvidia nem készül az általános felhasználói vonalat erõsítõ termékekkel, egyszerûen csak el kell fogadnunk a tényt, hogy a legnagyobb bevétel az ipari felhasználású fejlesztésekbõl származik.

Videokártya ventilátor zörög? Gyors hibakeresési útmutató

Videokártya ventilátor zörög, és hirtelen azon kapod magad, hogy a géped hangosabb, mint valaha. Ez az a jelenség, amit nem érdemes félvállról venni. A zörgő hang nemcsak idegesítő, hanem sokszor arra utal, hogy valami nincs rendben a hűtéssel. Ha időben reagálsz, megúszhatod komolyabb meghibásodás nélkül.

Ebben az útmutatóban végigvezetlek a lehetséges okokon, a diagnosztika lépésein és azon is, mikor érdemes szakemberhez fordulni.

Miért kezd el zörögni a videokártya ventilátora?

Hogyan állapítsd meg pontosan honnan jön a zaj?

A por mint alattomos ellenség

Csapágy problémák és kopás

Rezonancia és laza rögzítés

Szoftveres tényezők és ventilátor profilok

Mikor kell komolyan venni a problémát?

Megelőzés és hosszú távú karbantartás

Gyakran ismételt kérdések

Miért kezd el zörögni a videokártya ventilátora?

A modern videokártyák összetett hűtési rendszerrel működnek. A ventilátor feladata az, hogy a hűtőbordákon keresztül áramoltassa a levegőt, így elvezesse a hőt a GPU-ról és a memóriáról. Amikor a rendszer csendesen működik, észre sem veszed. Amikor viszont zörögni kezd, az már egy mechanikai vagy szerkezeti probléma jele.

A leggyakoribb ok a por. A finom porszemcsék idővel bejutnak a ventilátor csapágyazásába és a lapátok köré. Ez egyenetlen mozgást okozhat, ami vibrációval és zörgő hanggal jár

Videókártya hőmérséklet: Mennyi az ideális

Videókártya hőmérséklet az egyik legfontosabb mutató, ha stabil, gyors és hosszú élettartamú számítógépet szeretnél. Mégis meglepően sokan csak akkor kezdenek el vele foglalkozni, amikor már hangos a gép, akadozik a játék, vagy váratlanul újraindul a rendszer. Pedig a megfelelő hőfok nemcsak teljesítménykérdés, hanem komoly befektetésvédelem is.

Ebben a cikkben végigvezetlek azon, hogy mit tekinthetünk ideális értéknek, mikor kell aggódnod, mi befolyásolja a hőmérsékletet, és hogyan tudod kordában tartani anélkül, hogy rögtön hardvercserében gondolkodnál.

Miért kulcskérdés a videókártya hőmérséklet?

Mennyi az ideális érték játék és terhelés közben?

Mikor számít túl magasnak a hőmérséklet?

Mi befolyásolja a GPU melegedését?

Hogyan tudod ellenőrizni a hőmérsékletet?

Mit tehetsz, ha túl magas az érték?

A hőmérséklet és az élettartam kapcsolata

Gyakran ismételt kérdések

Összegzés

Miért kulcskérdés a videókártya hőmérséklet?

A grafikus kártya az egyik legnagyobb terhelésnek kitett alkatrész a gépedben. Játék közben, 3D modellezésnél, videóvágásnál vagy akár mesterséges intelligenciát használó szoftverek futtatásakor folyamatosan maximális teljesítmény közelében dolgozik. Ez jelentős hőtermeléssel jár.

A modern GPU-k beépített védelemmel rendelkeznek, így túlmelegedés esetén visszaveszik az óra

Videókártya csere lépésről lépésre: teljes útmutató kezdőknek és haladóknak

A videókártya csere elsőre ijesztőnek tűnhet, de ha követed a folyamatot lépésről lépésre, kiderül, hogy nem kell hozzá semmilyen titkos számítógépes tudás.

Akár most vásároltál új videókártyát, akár a régi teljesítménye nem elég a játékokhoz vagy a munkádhoz, ez a cikk végigvezet azon, hogyan oldhatod meg biztonságosan és hatékonyan a cserét.

Miért érdemes cserélni a videókártyát?

Felkészülés a cserére

A régi kártya eltávolítása

Új kártya beszerelése

Driver telepítés és beállítások

Hőmérséklet és teljesítmény ellenőrzés

Tippek haladóknak

Gyakran ismételt kérdések

Összegzés

Miért érdemes cserélni a videókártyát?

Az első lépés, hogy tisztában legyél az okokkal. Lehet, hogy a régi kártyád már nem bírja a modern játékok vagy programok terhelését, esetleg gyakran túlmelegszik. Mások a bővítési lehetőségek miatt váltanak, például több monitor vagy jobb VR élmény érdekében. A videókártya csere tehát nem csak a teljesítményről szól, hanem a használati élményről is.

Ha tudod, miért váltasz, könnyebb lesz a következő lépésekben dönteni a hardverről és az előkészületekről.

Felkészülés a cserére

Mielőtt nekiállsz, fontos, hogy minden szükséges eszköz kéznél legyen. Ellenőrizd a számítógéped tápellátását, a ház méretét és a csatlakozó